En los últimos meses, la comunidad de la inteligencia artificial se ha visto sacudida por un acalorado debate desencadenado por dos influyentes trabajos de investigación publicados por apple. El primero, " La ilusión de pensar" ( illusion-of-thinking-the-debate-that-is-shaking-the-world-of-ai&_bhlid=a540c17e5de7c2723906dabd9b8f31cdf0c5bf18" target="_blank" id="">"GSM-Symbolic" (octubre de 2024), y el segundo, "La ilusión de pensar" (junio de 2025), cuestionaban la supuesta capacidad de razonamiento de los grandes modelos lingüísticos, provocando reacciones encontradas en todo el sector.

Como ya analizamos en nuestro anterior artículo sobre «La ilusión del progreso: simular la inteligencia artificial general sin alcanzarla», la cuestión del razonamiento artificial toca el núcleo mismo de lo que consideramos inteligencia en las máquinas.

Los investigadores de Apple llevaron a cabo un análisis sistemático de los modelos de razonamiento de gran tamaño (LRM), es decir, aquellos modelos que generan trazas detalladas de razonamiento antes de proporcionar una respuesta. Los resultados fueron sorprendentes y, para muchos, alarmantes.

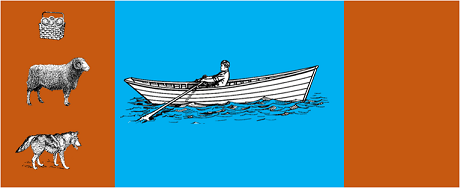

El estudio sometió los modelos más avanzados a rompecabezas algorítmicos clásicos como:

Los resultados mostraron que incluso pequeños cambios en la formulación del problema provocan variaciones significativas en el rendimiento, lo que sugiere una preocupante fragilidad en el razonamiento. Como se informó en cobertura de AppleInsider"el rendimiento de todos los modelos disminuye cuando sólo se alteran los valores numéricos en las preguntas de referencia GSM-Symbolic".

La respuesta de la comunidad de la IA no se hizo esperar. Alex Lawsen, de Open Philanthropy, en colaboración con Claude Opus, de Anthropic, publicó una refutación detallada titulada "La ilusión de pensarrebatiendo las metodologías y conclusiones del estudio de Apple.

Cuando Lawsen repitió las pruebas con metodologías alternativas -pidiendo a los modelos que generaran funciones recursivas en lugar de enumerar todos los movimientos- los resultados fueron radicalmente distintos. Modelos como Claude, gemini y GPT resolvieron correctamente problemas de la Torre de Hanoi con 15 registros, muy por encima de la complejidad en la que Apple informó de cero aciertos.

Gary Marcuscrítico durante mucho tiempo de la capacidad de razonamiento de los LLM, acogió los hallazgos de Apple como una confirmación de su tesis de 20 años. Según Marcus, los LLM siguen teniendo problemas con el "cambio de distribución" -la capacidad de generalizar más allá de los datos de entrenamiento-, al tiempo que siguen siendo "buenos solucionadores de problemas que ya han sido resueltos".

El debate también se ha extendido a comunidades especializadas como LocalLlama en Redditdonde desarrolladores e investigadores debaten sobre las implicaciones prácticas de los modelos de código abierto y la implantación local.

Este debate no es puramente académico. Tiene implicaciones directas para:

Como se destaca en varias reflexiones técnicascada vez son más necesarios planteamientos híbridos que combinen:

Ejemplo trivial: un asistente de IA que ayuda con la contabilidad. El modelo lingüístico entiende cuando preguntas "¿cuánto me he gastado en viajes este mes?" y extrae los parámetros pertinentes (categoría: viajes, periodo: este mes). ¿Pero la consulta SQL que consulta la base de datos, calcula la suma y comprueba las restricciones fiscales? Eso lo hace el código determinista, no el modelo neuronal.

A los observadores no se les pasó por alto que el documento de Apple se publicó poco antes de la WWDC, lo que suscita dudas sobre las motivaciones estratégicas. Según elanálisis de 9to5Macel momento en que se publicó el artículo de Apple, justo antes de la WWDC, suscitó algunas dudas. ¿Se trataba de un hito en la investigación o de un movimiento estratégico para reposicionar a Apple en el panorama más amplio de la IA?".

El debate suscitado por los documentos de Apple nos recuerda que aún estamos en las primeras fases de comprensión de la inteligencia artificial. Como señalábamos en nuestro artículo anteriorla distinción entre simulación y razonamiento auténtico sigue siendo uno de los retos más complejos de nuestro tiempo.

La verdadera lección no es si los LLM pueden o no "razonar" en el sentido humano del término, sino cómo podemos construir sistemas que exploten sus puntos fuertes al tiempo que compensan sus limitaciones. En un mundo en el que la IA ya está transformando sectores enteros, la cuestión ya no es si estas herramientas son "inteligentes", sino cómo utilizarlas de forma eficaz y responsable.

El futuro de la IA empresarial probablemente no radique en un único enfoque revolucionario, sino en la orquestación inteligente de varias tecnologías complementarias. Y en este escenario, la capacidad de evaluar de forma crítica y honesta las capacidades de nuestras herramientas se convierte en una ventaja competitiva en sí misma.

Últimos avances (enero de 2026)

OpenAI lanza o3 y o4-mini: El 16 de abril de 2025, OpenAI lanzó públicamente o3 y o4-mini, los modelos de razonamiento más avanzados de la serie o. Estos modelos ahora pueden utilizar herramientas de forma autónoma, combinando búsqueda web, análisis de archivos, razonamiento visual y generación de imágenes. o3 ha establecido nuevos récords en benchmarks como Codeforces, SWE-bench y MMMU, mientras que o4-mini optimiza el rendimiento y los costes para tareas de razonamiento de gran volumen. Los modelos demuestran su capacidad de «pensar con imágenes», transformando visualmente el contenido para un análisis más profundo.

DeepSeek-R1 revoluciona la industria de la IA: en enero de 2025, DeepSeek lanzó R1, un modelo de razonamiento de código abierto que alcanzó un rendimiento comparable al de OpenAI o1 con un coste de entrenamiento de solo 6 millones de dólares (frente a los cientos de millones de los modelos occidentales). DeepSeek-R1 demuestra que las capacidades de razonamiento pueden fomentarse mediante el aprendizaje por refuerzo puro, sin necesidad de demostraciones humanas anotadas. El modelo se convirtió en la aplicación gratuita n.º 1 en la App Store y Google Play en decenas de países. En enero de 2026, DeepSeek publicó un extenso artículo de 60 páginas en el que revela los secretos del entrenamiento y admite con franqueza que técnicas como la búsqueda en árbol de Monte Carlo (MCTS) no han funcionado para el razonamiento general.

Anthropic actualiza la «Constitución» de Claude: El 22 de enero de 2026, Anthropic publicó una nueva constitución de 23 000 palabras para Claude, pasando de un enfoque basado en reglas a uno basado en la comprensión de los principios éticos. El documento se convierte en el primer marco de una gran empresa de IA que reconoce formalmente la posibilidad de la conciencia o el estatus moral de la IA, afirmando que Anthropic se preocupa por el «bienestar psicológico, el sentido de identidad y el bienestar» de Claude.

El debate se intensifica: un estudio realizado en julio de 2025 replicó y perfeccionó los parámetros de referencia de Apple, confirmando que los LRM siguen mostrando limitaciones cognitivas cuando la complejidad aumenta moderadamente (alrededor de 8 discos en la Torre de Hanoi). Los investigadores demostraron que esto no solo depende de las limitaciones de rendimiento, sino también de limitaciones cognitivas reales, lo que pone de manifiesto que el debate está lejos de haber concluido.

Para obtener información sobre la estrategia de IA de su organización y la implantación de soluciones sólidas, nuestro equipo de expertos está a su disposición para consultas personalizadas.